1 安装前准备

具体步骤参见 我的另一篇博文 如何设置k8s安装前的计算机环境如何设置k8s安装前的计算机环境(此处有超链接,可以直接点击跳转)。

K8S版本:1.23.6

2.添加阿里云yum软件源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

3. 安装kubeadm和kubelet

kubeadm和kubelet的版本更新速度还是比较快,最好指定版本号。写作本文时,最新的版本号1.23.6。但为了稳定起见,我这里用的是低两个版本的1.23.6。

yum install -y kubelet-1.23.6 kubeadm-1.23.6

systemctl enable kubelet

4.4 部署kubernetes master

在Master节点上的任意路径下输入执行以下命令:

kubeadm init \

--apiserver-advertise-address=192.168.101.17 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.23.6 \

--service-cidr=10.96.0.0/12 \

--pod-network-cidr=10.244.0.0/16 \

--ignore-preflight-errors=all

参数说明

- apiserver-advertise-address 集群通告地址

- image-repository 由于默认拉取镜像地址k8s.gcr.io国内无法访问,这里指定阿里云镜像仓库地址

- kubernetes-version K8s版本,与上面安装的一致

- service-cidr 集群内部虚拟网络,Pod统一访问入口

- pod-network-cidr Pod网络,与下面部署的CNI网络组件yaml中保持一致

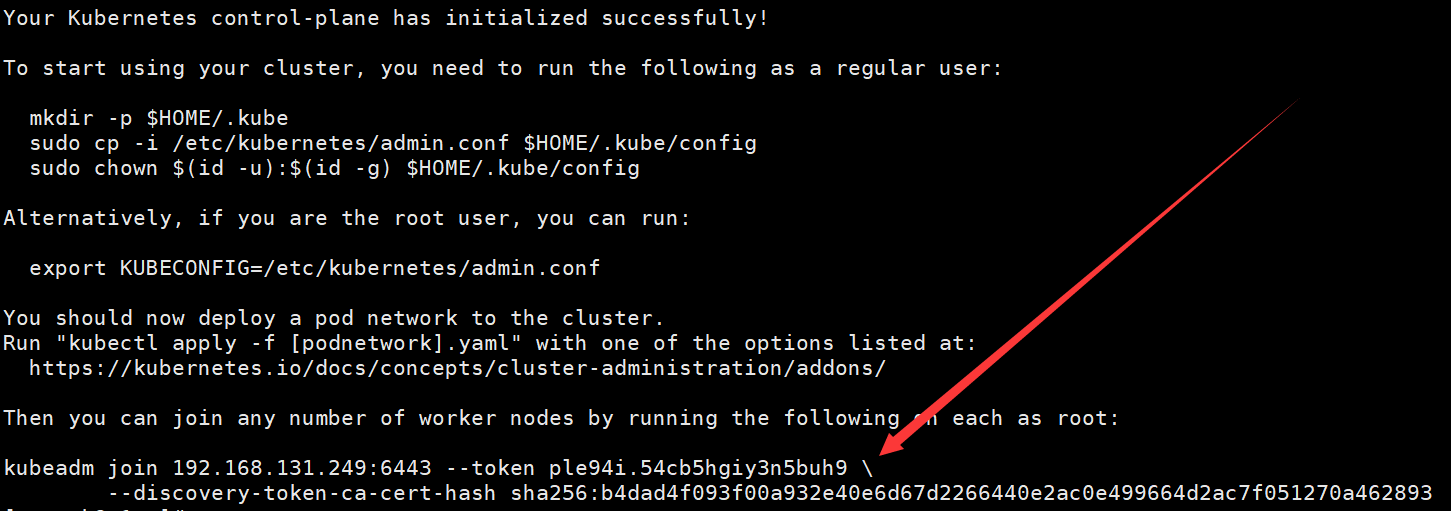

初始化完成后,最后会输出一个join命令,先记住,下面用。

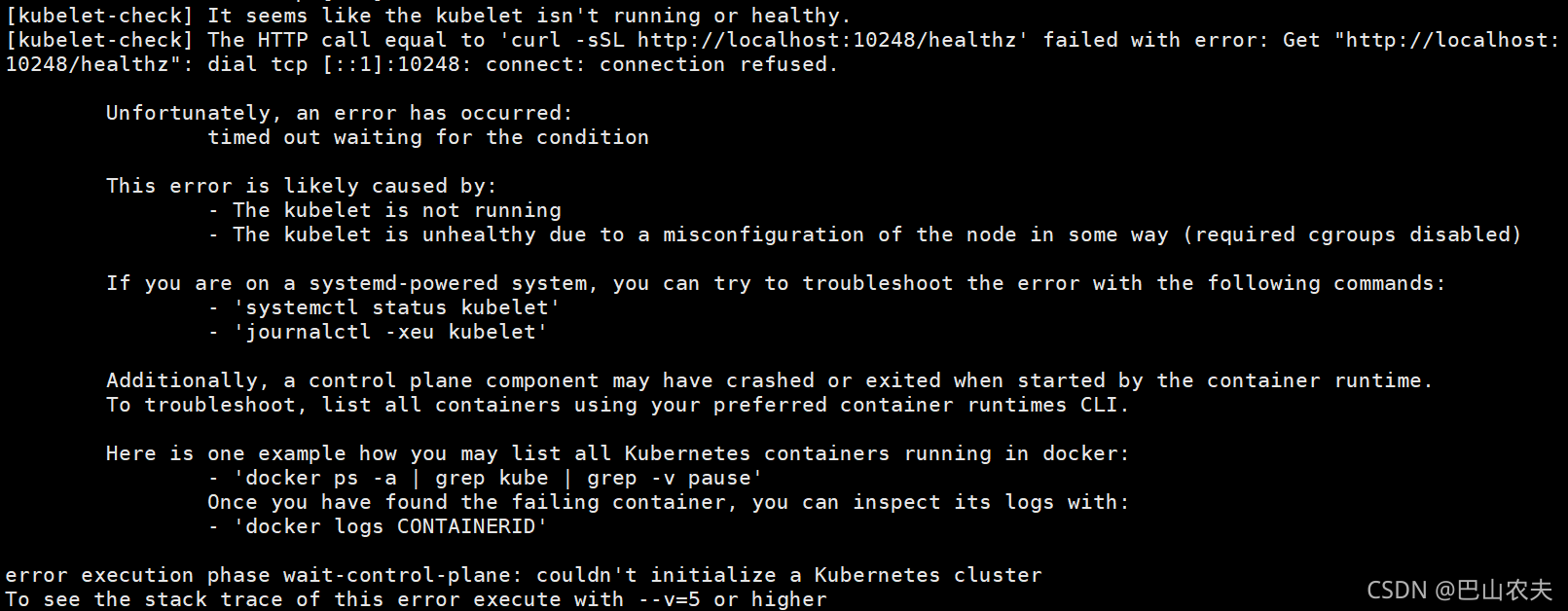

可能遇到的问题

在这个过程中可能会遇到如下报错:

日志提示是kubelet启动失败。而最常见的可能是docker和k8s的cgroupDriver不一致造成的。

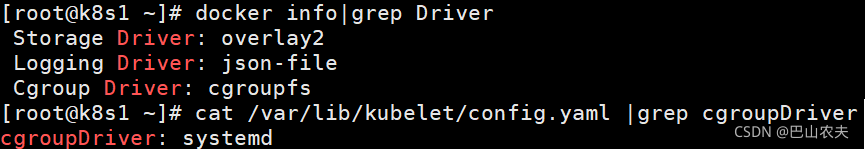

先核实推测是否正确,运行 docker info|grep Driver 和 cat /var/lib/kubelet/config.yaml |grep cgroupDriver 对比两者的结果。如果是下图这样,那就证实了推测,否则,您需要找其他原因。

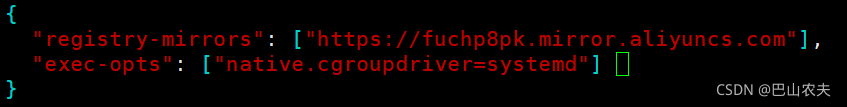

如果是因为cgroupDriver 不一致造成的,我们一般是修改docker。方法就是运行 vi /etc/docker/daemon.json 以修改docker原有的配置文件,在其中加入一行, “exec-opts”: [“native.cgroupdriver=systemd”],但请主要补齐必要的英文逗号,以保证json格式正确。如图所示:

这个在准备工作的时候已经先添加上去了

然后读取新的配置文件,重启docker就可以解决这个问题

# 导入镜像设置

systemctl daemon-reload

# 重启docker

systemctl restart docker

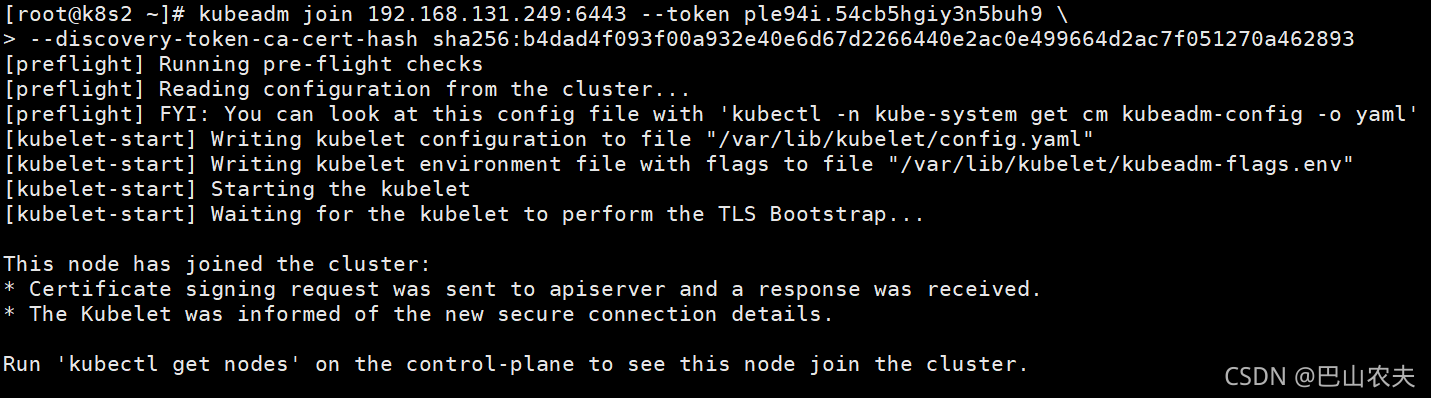

5 加入kubernetes node

在Node节点(示例中为192.168.101.18,192.168.101.19)上执行。

向集群添加新节点,执行之前记录的kubeadm join命令:

默认token有效期为24小时,当过期之后,该token就不可用了。这时就需要重新创建token,可以直接使用命令快捷生成:

kubeadm token create --print-join-command

6 配置kubectl

实际上,kubectl可以部署到任意计算机上,只需要这台计算机和master节点联网,即使是Windows系统也是可以的。将文件放入指定地址就可以完成配置。这里我们就将kubectl部署在master节点。

拷贝kubectl使用的连接k8s认证文件到默认路径:

#通常在安装kubeadm,kubelet时会自动安装kubectl,但每个版本

yum install -y kubectl-1.23.6

#下列命令也会在kubeadm init命令执行成功后提示。

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

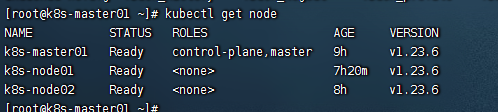

执行完成后,可以输入命令kubectl get nodes验证安装配置kubectl的情况,如图所示:

因为没有部署网络组件,上面的节点应该是NotReady才是正常的

7.部署容器网络

Calico是一个纯三层的数据中心网络方案,是目前Kubernetes主流的网络方案。

输入命令wget https://docs.projectcalico.org/manifests/calico.yaml,以下载yaml。

下载完后,需要修改字段CALICO_IPV4POOL_CIDR,与前面kubeadm init命令中的 --pod-network-cidr参数一样。

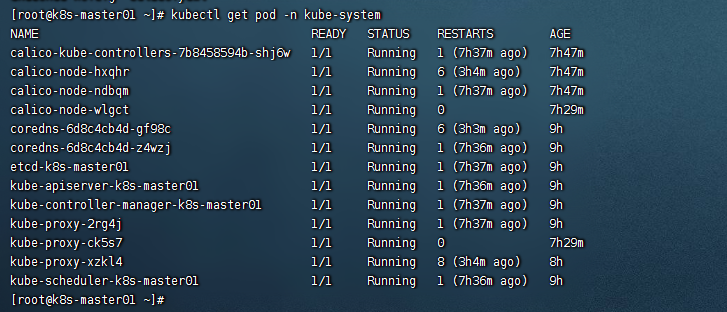

修改完后文件后,输入命令kubectl apply -f calico.yaml执行部署容器网络。稍等几分钟,然后执行kubectl get pods -n kube-system查看部署进度。等Calico Pod都Running,节点也会准备就绪。

yaml文件已经放到云盘

8.测试kubernetes集群

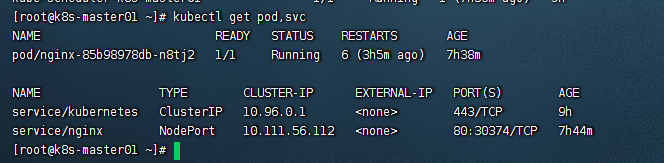

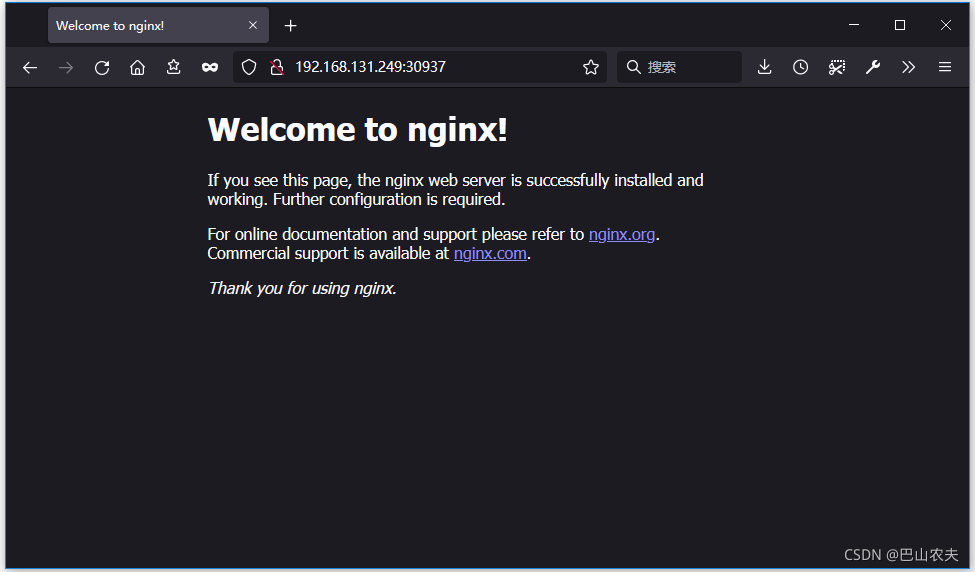

在Kubernetes集群中创建一个pod,验证是否正常运行:

kubectl create deployment nginx --image=nginx

kubectl expose deployment nginx --port=80 --type=NodePort

kubectl get pod,svc

访问地址:http://<任意Node的IP>:Port ,如:

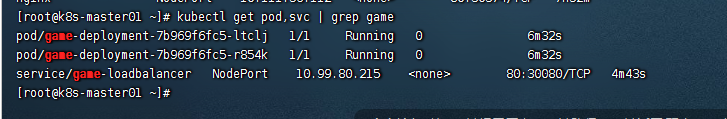

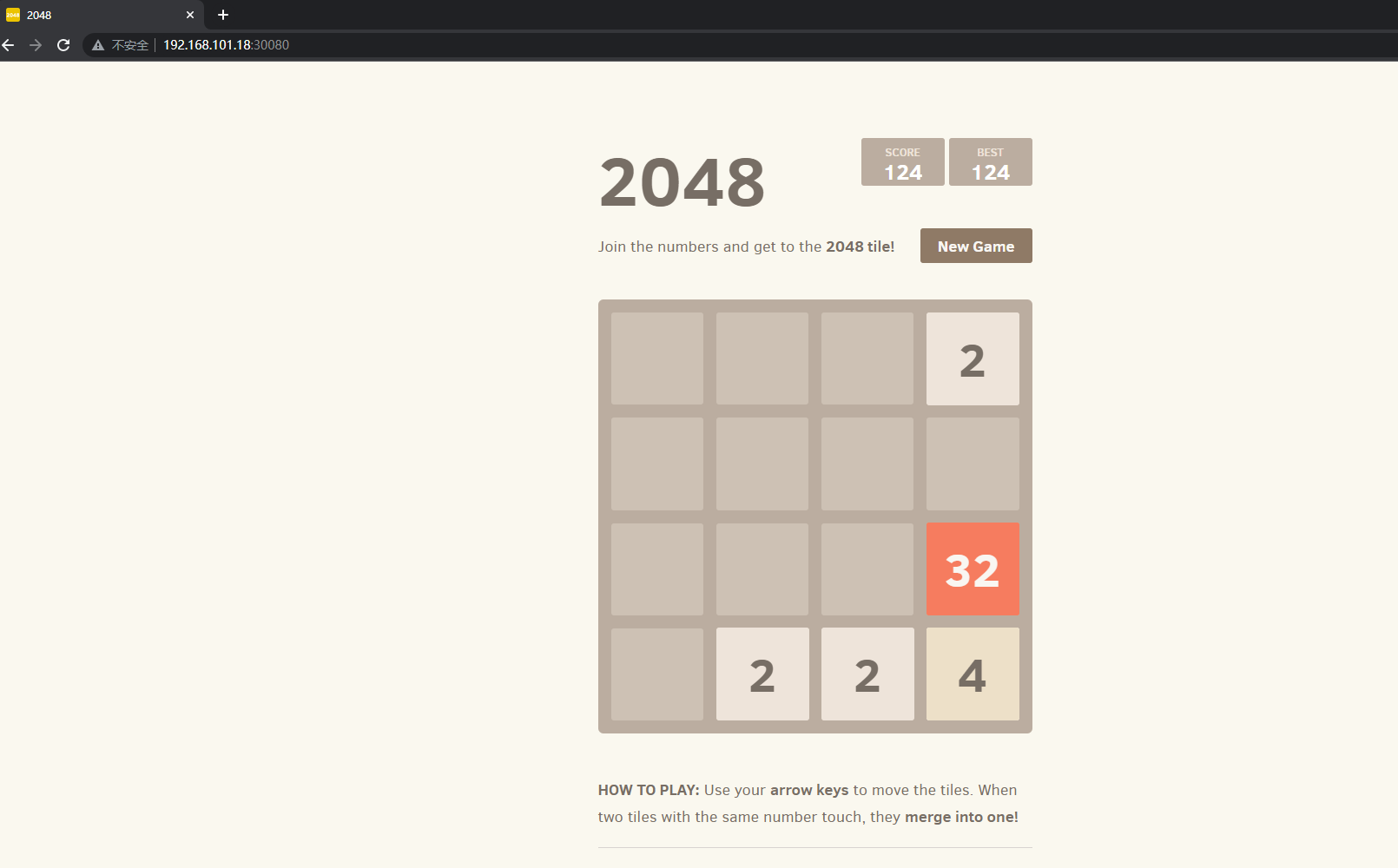

9.在kubernetes集群中测试部署小游戏2048

使用k8s编排容器,部署一个deploy, 还能高可用

cat > game-deploy.yaml << EOF

apiVersion: apps/v1

kind: Deployment

metadata:

name: game-deployment

spec:

selector:

matchLabels:

app: game

replicas: 2

template:

metadata:

labels:

app: game

spec:

containers:

- name: game

image: blackicebird/2048

ports:

- containerPort: 80

EOF

# 刚才查到的star多的镜像写上去

kubectl create -f game-deploy.yaml

部署路由,外部访问

还是先起一个NodePort服务,让客户端可以访问到pod, 注意标签对应deploy的标签, targetPort端口是pod的端口.

cat > game-loadbalancer.yaml << EOF

apiVersion: v1

kind: Service

metadata:

name: game-loadbalancer

spec:

type: NodePort

ports:

- port: 80

targetPort: 80

nodePort: 30080

selector:

app: game

EOF

# 启动

kubectl create -f game-loadbalancer.yaml

效果图:

评论区